Comprendre correctement l'apprentissage profond

|

Description

Introduction au livre

Au-delà des modèles complexes, il est temps de plonger au cœur de l'apprentissage profond.

Ce livre dévoile de manière intuitive les rouages de la technologie complexe d'apprentissage profond tout en maintenant un équilibre entre théorie et pratique.

Nous allons d'abord expliquer étape par étape les concepts de base qui sous-tendent l'apprentissage profond.

Après avoir abordé les bases de l'apprentissage supervisé et de l'architecture des réseaux neuronaux, de l'entraînement des modèles et de l'optimisation, nous examinerons des modèles représentatifs pour les données d'images, de texte et de graphes : les CNN, les transformateurs et les réseaux neuronaux de graphes.

Ensuite, nous abordons les modèles génératifs tels que les GAN, les VAE et les modèles de diffusion, ainsi que l'apprentissage par renforcement, et enfin, nous discutons des raisons théoriques de l'efficacité de l'apprentissage profond et examinons les questions éthiques.

Ce sera le point de départ le plus solide pour tous les lecteurs qui souhaitent bien comprendre l'apprentissage profond.

Ce livre dévoile de manière intuitive les rouages de la technologie complexe d'apprentissage profond tout en maintenant un équilibre entre théorie et pratique.

Nous allons d'abord expliquer étape par étape les concepts de base qui sous-tendent l'apprentissage profond.

Après avoir abordé les bases de l'apprentissage supervisé et de l'architecture des réseaux neuronaux, de l'entraînement des modèles et de l'optimisation, nous examinerons des modèles représentatifs pour les données d'images, de texte et de graphes : les CNN, les transformateurs et les réseaux neuronaux de graphes.

Ensuite, nous abordons les modèles génératifs tels que les GAN, les VAE et les modèles de diffusion, ainsi que l'apprentissage par renforcement, et enfin, nous discutons des raisons théoriques de l'efficacité de l'apprentissage profond et examinons les questions éthiques.

Ce sera le point de départ le plus solide pour tous les lecteurs qui souhaitent bien comprendre l'apprentissage profond.

- Vous pouvez consulter un aperçu du contenu du livre.

Aperçu

indice

Préface du traducteur xiii

Revue du lecteur bêta xiv

À partir du XVIIe siècle

Remerciements xix

CHAPITRE 01 Introduction 1

1.1 Apprentissage supervisé 2

1.2 Apprentissage non supervisé 8

1.3 Apprentissage par renforcement 12

1.4 Éthique 14

1.5 Structure de ce livre 17

1.6 Livres recommandés 18

1.7 Comment lire ce livre 19

_Références 21

CHAPITRE 02 Apprentissage supervisé 23

2.1 Aperçu de l'apprentissage supervisé 24

2.2 Exemple de régression linéaire 25

2.3 Résumé 30

_Note 30

Exercice pratique 31

CHAPITRE 03 Réseaux neuronaux superficiels 33

3.1 Exemple 33 d'un réseau neuronal

3.2 Théorème d'approximation universelle 37

3.3 Entrée et sortie multivariées 38

3.4 Réseaux neuronaux superficiels : Cas général 43

3.5 Terminologie 44

3.6 Résumé 45

_Note 46

Exercice 50

_Référence 53

CHAPITRE 04 Réseaux neuronaux profonds 55

4.1 Combinaison de réseaux neuronaux 55

4.2 Construction d'un réseau neuronal profond par combinaison de réseaux 58

4.3 Réseaux neuronaux profonds 59

4.4 Notation matricielle 63

4.5 Réseaux neuronaux superficiels vs.

Réseaux neuronaux profonds 65

4.6 Résumé 67

_Note 68

Exercice 71

_Références 74

CHAPITRE 05 Fonction de perte 75

5.1 Probabilité maximale 76

5.2 Comment construire une fonction de perte 80

5.3 Exemple 1 : Analyse de régression univariée 80

5.4 Exemple 2 : Classification binaire 86

5.5 Exemple 3 : Classification multiclasse 88

5.6 Sorties multiples 91

5.7 Perte d'entropie croisée 92

5.8 Résumé 94

_Note 95

Exercice 97

_Références 101

CHAPITRE 06 MODÈLE ADAPTÉ 103

6.1 Descente en pente 103

6.2 Descente de gradient stochastique 110

6.3 Momentum 113

6.4 Estimation adaptative du moment 115

6.5 Hyperparamètres de l'algorithme d'entraînement 118

6.6 Résumé 119

_Note 120

Exercice 124

_Références 127

CHAPITRE 07 Pente et initialisation 129

7.1 Définition du problème 129

7.2 Calcul différentiel 131

7.3 Exemple simple 133

7.4 Algorithme de rétropropagation 137

7.5 Initialisation des paramètres 143

7.6 Exemple de code de formation 147

7.7 Résumé 149

_Note 149

Exercice 153

_Références 157

CHAPITRE 08 MESURE DES PERFORMANCES 159

8.1 Entraînement d'un modèle simple 159

8.2 Causes d'erreur 161

8.3 Réduction des erreurs 166

8.4 Double Descente 170

8.5 Sélection des hyperparamètres 174

8.6 Résumé 175

_Note 176

Exercice 181

_Références 183

CHAPITRE 09 Régularisation 185

9.1 Régularisation explicite 185

9.2 Régularisation implicite 189

9.3 Méthodes empiriques pour améliorer la performance 192

9.4 Résumé 202

_Note 203

Exercice 212

_Références 214

CHAPITRE 10 : Réseaux convolutionnels 219

10.1 Invariance et isovariance 220

10.2 Réseaux de neurones convolutifs pour entrées unidimensionnelles 221

10.3 Réseaux de neurones convolutifs pour entrées bidimensionnelles 229

10.4 Sous-échantillonnage et suréchantillonnage 230

10.5 Application 233

10.6 Résumé 239

_Note 240

Exercice 246

_Références 249

CHAPITRE 11 : Réseaux neuronaux résiduels 253

11.1 Traitement séquentiel 253

11.2 Liaison résiduelle et bloc résiduel 256

11.3 Explosion du gradient dans les réseaux neuronaux résiduels 260

11.4 Normalisation par lots 262

11.5 Réseaux neuronaux résiduels généraux 264

11.6 Pourquoi les réseaux neuronaux avec connexions résiduelles sont plus performants 271

11.7 Résumé 272

_Note 272

Exercice 280

_Références 282

CHAPITRE 12 TRANSFORMATEURS 285

12.1 Traitement des données textuelles 285

12.2 Auto-attention du produit scalaire 286

12.3 Extension d'auto-attention au produit scalaire 292

Couche 12.4 Transformateur 295

12.5 Transformateurs pour le traitement automatique du langage naturel 296

12.6 Exemple de modèle d'encodeur : BERT 300

12.7 Exemple de modèle de décodeur : GPT-3 303

12.8 Exemple de modèle encodeur-décodeur : Traduction automatique 308

12.9 Transformer 310 pour le traitement de séquences longues

12.10 Transformateurs pour le traitement d'images 311

12.11 Résumé 316

_Note 316

Exercice 328

_Références 330

CHAPITRE 13 : Réseaux neuronaux graphiques 337

13.1 Qu'est-ce qu'un graphique ? 337

13.2 Représentation graphique 340

13.3 Réseaux neuronaux graphiques, tâches et fonctions de perte 344

13.4 Réseaux de convolution de graphes 346

13.5 Exemple de classification de graphes 349

13.6 Modèle inductif vs.

Modèle transitoire 350

13.7 Exemple de classification des nœuds 352

13.8 Couche 355 du réseau de convolution de graphes

13.9 Edge Graph 359

13.10 Résumé 360

_Note 361

Exercice 370

_Références 373

CHAPITRE 14 Apprentissage non supervisé 377

14.1 Classification par modèle d'apprentissage non supervisé 378

14.2 Caractéristiques d'un bon modèle génératif 380

14.3 Quantification des performances 381

14.4 Résumé 384

_Note 384

_Références 386

CHAPITRE 15 : Réseaux antagonistes génératifs 387

15.1 Utilisation du discriminant comme signal 387

15.2 Améliorations de la stabilité 393

15.3 Augmentation progressive, discrimination par mini-lots, troncature 399

15.4 Génération conditionnelle 402

15.5 Conversion d'image 405

15.6 StyleGAN 410

15.7 Résumé 412

_Note 413

Exercice 419

_Références 421

CHAPITRE 16 Flux de normalisation 427

16.1 Exemple unidimensionnel 427

16.2 Cas général 430

16.3 Couches de réseaux neuronaux inversibles 433

16.4 Écoulement multi-échelle 442

16.5 Application 443

16.6 Résumé 447

_Note 448

Exercice 453

_Références 456

CHAPITRE 17 Auto-encodeurs variationnels 461

17.1 Modèle à variable latente 461

17.2 Modèles à variables latentes non linéaires 463

17.3 Formation 465

17.4 Propriétés ELBO 468

17.5 Approximation variationnelle 470

17.6 Auto-encodeurs variationnels 471

17.7 Techniques de reparamétrisation 474

17.8 Application 475

17.9 Résumé 480

_Note 481

Exercice 486

_Références 488

CHAPITRE 18 Modèles de diffusion 493

18.1 Vue d'ensemble 493

18.2 Encodeur (passe avant) 494

18.3 Modèle de décodeur (processus inverse) 501

18.4 Formation 502

18.5 Reparamétrisation de la fonction de perte 507

18.6 Mise en œuvre 510

18.7 Résumé 516

_Note 516

Exercice 521

_Références 524

CHAPITRE 19 : RENFORCEMENT DES APPRENTISSAGES 527

19.1 Processus de décision markoviens, rendements et politiques 528

19.2 Rendement attendu 532

19.3 Apprentissage par renforcement tabulaire 536

19.4 Q-Learning Fit 541

19.5 Méthode du gradient de politique 545

19.6 La méthode acteur-critique 551

19.7 Apprentissage par renforcement hors ligne 552

19.8 Résumé 554

_Note 555

Exercice 561

_Références 564

CHAPITRE 20 : Pourquoi l’apprentissage profond est-il efficace ? 567

20.1 Arguments contre l'apprentissage profond 567

20.2 Facteurs affectant la performance d'ajustement 569

20.3 Caractéristiques de la fonction de perte 575

20.4 Déterminants de généralisation 579

20.5 Avons-nous vraiment besoin d'autant de paramètres ? 584

20.6 Les réseaux neuronaux doivent-ils être profonds ? 587

20.7 Résumé 590

Exercice 591

_Références 592

CHAPITRE 21 : Apprentissage profond et éthique 597

21.1 Alignement des valeurs 598

21.2 Utilisation abusive intentionnelle 606

21.3 Autres questions sociales, éthiques et professionnelles 608

21.4 Étude de cas 611

21.5 L'idéal de science neutre sur le plan axiologique 612

21.6 Recherche responsable en IA dans une perspective de problème d'action collective 614

21.7 La voie à suivre 615

21.8 Résumé 617

Exercice 618

_Références 620

ANNEXE A Notation 627

A.1 Scalaires, vecteurs, matrices et tenseurs 627

A.2 Variables et paramètres 627

A.3 Ensemble 628

A.4 Fonction 628

A.5 Minimisation et maximisation 629

A.6 Distribution de probabilité 629

A.7 Notation asymptotique 630

A.8 Autres 630

ANNEXE B Concepts mathématiques 631

B.1 Fonction 631

B.2 Coefficient binomial 634

B.3 Vecteurs, matrices et tenseurs 635

B.4 Formes particulières de matrices 639

B.5 Calcul matriciel 641

ANNEXE C Probabilité 643

C.1 Variables aléatoires et distributions de probabilité 643

C.2 Valeur attendue 647

C.3 Distribution de probabilité normale 652

C.4 Échantillonnage 656

C.5 Distance entre les distributions de probabilité 657

Recherche 661

Revue du lecteur bêta xiv

À partir du XVIIe siècle

Remerciements xix

CHAPITRE 01 Introduction 1

1.1 Apprentissage supervisé 2

1.2 Apprentissage non supervisé 8

1.3 Apprentissage par renforcement 12

1.4 Éthique 14

1.5 Structure de ce livre 17

1.6 Livres recommandés 18

1.7 Comment lire ce livre 19

_Références 21

CHAPITRE 02 Apprentissage supervisé 23

2.1 Aperçu de l'apprentissage supervisé 24

2.2 Exemple de régression linéaire 25

2.3 Résumé 30

_Note 30

Exercice pratique 31

CHAPITRE 03 Réseaux neuronaux superficiels 33

3.1 Exemple 33 d'un réseau neuronal

3.2 Théorème d'approximation universelle 37

3.3 Entrée et sortie multivariées 38

3.4 Réseaux neuronaux superficiels : Cas général 43

3.5 Terminologie 44

3.6 Résumé 45

_Note 46

Exercice 50

_Référence 53

CHAPITRE 04 Réseaux neuronaux profonds 55

4.1 Combinaison de réseaux neuronaux 55

4.2 Construction d'un réseau neuronal profond par combinaison de réseaux 58

4.3 Réseaux neuronaux profonds 59

4.4 Notation matricielle 63

4.5 Réseaux neuronaux superficiels vs.

Réseaux neuronaux profonds 65

4.6 Résumé 67

_Note 68

Exercice 71

_Références 74

CHAPITRE 05 Fonction de perte 75

5.1 Probabilité maximale 76

5.2 Comment construire une fonction de perte 80

5.3 Exemple 1 : Analyse de régression univariée 80

5.4 Exemple 2 : Classification binaire 86

5.5 Exemple 3 : Classification multiclasse 88

5.6 Sorties multiples 91

5.7 Perte d'entropie croisée 92

5.8 Résumé 94

_Note 95

Exercice 97

_Références 101

CHAPITRE 06 MODÈLE ADAPTÉ 103

6.1 Descente en pente 103

6.2 Descente de gradient stochastique 110

6.3 Momentum 113

6.4 Estimation adaptative du moment 115

6.5 Hyperparamètres de l'algorithme d'entraînement 118

6.6 Résumé 119

_Note 120

Exercice 124

_Références 127

CHAPITRE 07 Pente et initialisation 129

7.1 Définition du problème 129

7.2 Calcul différentiel 131

7.3 Exemple simple 133

7.4 Algorithme de rétropropagation 137

7.5 Initialisation des paramètres 143

7.6 Exemple de code de formation 147

7.7 Résumé 149

_Note 149

Exercice 153

_Références 157

CHAPITRE 08 MESURE DES PERFORMANCES 159

8.1 Entraînement d'un modèle simple 159

8.2 Causes d'erreur 161

8.3 Réduction des erreurs 166

8.4 Double Descente 170

8.5 Sélection des hyperparamètres 174

8.6 Résumé 175

_Note 176

Exercice 181

_Références 183

CHAPITRE 09 Régularisation 185

9.1 Régularisation explicite 185

9.2 Régularisation implicite 189

9.3 Méthodes empiriques pour améliorer la performance 192

9.4 Résumé 202

_Note 203

Exercice 212

_Références 214

CHAPITRE 10 : Réseaux convolutionnels 219

10.1 Invariance et isovariance 220

10.2 Réseaux de neurones convolutifs pour entrées unidimensionnelles 221

10.3 Réseaux de neurones convolutifs pour entrées bidimensionnelles 229

10.4 Sous-échantillonnage et suréchantillonnage 230

10.5 Application 233

10.6 Résumé 239

_Note 240

Exercice 246

_Références 249

CHAPITRE 11 : Réseaux neuronaux résiduels 253

11.1 Traitement séquentiel 253

11.2 Liaison résiduelle et bloc résiduel 256

11.3 Explosion du gradient dans les réseaux neuronaux résiduels 260

11.4 Normalisation par lots 262

11.5 Réseaux neuronaux résiduels généraux 264

11.6 Pourquoi les réseaux neuronaux avec connexions résiduelles sont plus performants 271

11.7 Résumé 272

_Note 272

Exercice 280

_Références 282

CHAPITRE 12 TRANSFORMATEURS 285

12.1 Traitement des données textuelles 285

12.2 Auto-attention du produit scalaire 286

12.3 Extension d'auto-attention au produit scalaire 292

Couche 12.4 Transformateur 295

12.5 Transformateurs pour le traitement automatique du langage naturel 296

12.6 Exemple de modèle d'encodeur : BERT 300

12.7 Exemple de modèle de décodeur : GPT-3 303

12.8 Exemple de modèle encodeur-décodeur : Traduction automatique 308

12.9 Transformer 310 pour le traitement de séquences longues

12.10 Transformateurs pour le traitement d'images 311

12.11 Résumé 316

_Note 316

Exercice 328

_Références 330

CHAPITRE 13 : Réseaux neuronaux graphiques 337

13.1 Qu'est-ce qu'un graphique ? 337

13.2 Représentation graphique 340

13.3 Réseaux neuronaux graphiques, tâches et fonctions de perte 344

13.4 Réseaux de convolution de graphes 346

13.5 Exemple de classification de graphes 349

13.6 Modèle inductif vs.

Modèle transitoire 350

13.7 Exemple de classification des nœuds 352

13.8 Couche 355 du réseau de convolution de graphes

13.9 Edge Graph 359

13.10 Résumé 360

_Note 361

Exercice 370

_Références 373

CHAPITRE 14 Apprentissage non supervisé 377

14.1 Classification par modèle d'apprentissage non supervisé 378

14.2 Caractéristiques d'un bon modèle génératif 380

14.3 Quantification des performances 381

14.4 Résumé 384

_Note 384

_Références 386

CHAPITRE 15 : Réseaux antagonistes génératifs 387

15.1 Utilisation du discriminant comme signal 387

15.2 Améliorations de la stabilité 393

15.3 Augmentation progressive, discrimination par mini-lots, troncature 399

15.4 Génération conditionnelle 402

15.5 Conversion d'image 405

15.6 StyleGAN 410

15.7 Résumé 412

_Note 413

Exercice 419

_Références 421

CHAPITRE 16 Flux de normalisation 427

16.1 Exemple unidimensionnel 427

16.2 Cas général 430

16.3 Couches de réseaux neuronaux inversibles 433

16.4 Écoulement multi-échelle 442

16.5 Application 443

16.6 Résumé 447

_Note 448

Exercice 453

_Références 456

CHAPITRE 17 Auto-encodeurs variationnels 461

17.1 Modèle à variable latente 461

17.2 Modèles à variables latentes non linéaires 463

17.3 Formation 465

17.4 Propriétés ELBO 468

17.5 Approximation variationnelle 470

17.6 Auto-encodeurs variationnels 471

17.7 Techniques de reparamétrisation 474

17.8 Application 475

17.9 Résumé 480

_Note 481

Exercice 486

_Références 488

CHAPITRE 18 Modèles de diffusion 493

18.1 Vue d'ensemble 493

18.2 Encodeur (passe avant) 494

18.3 Modèle de décodeur (processus inverse) 501

18.4 Formation 502

18.5 Reparamétrisation de la fonction de perte 507

18.6 Mise en œuvre 510

18.7 Résumé 516

_Note 516

Exercice 521

_Références 524

CHAPITRE 19 : RENFORCEMENT DES APPRENTISSAGES 527

19.1 Processus de décision markoviens, rendements et politiques 528

19.2 Rendement attendu 532

19.3 Apprentissage par renforcement tabulaire 536

19.4 Q-Learning Fit 541

19.5 Méthode du gradient de politique 545

19.6 La méthode acteur-critique 551

19.7 Apprentissage par renforcement hors ligne 552

19.8 Résumé 554

_Note 555

Exercice 561

_Références 564

CHAPITRE 20 : Pourquoi l’apprentissage profond est-il efficace ? 567

20.1 Arguments contre l'apprentissage profond 567

20.2 Facteurs affectant la performance d'ajustement 569

20.3 Caractéristiques de la fonction de perte 575

20.4 Déterminants de généralisation 579

20.5 Avons-nous vraiment besoin d'autant de paramètres ? 584

20.6 Les réseaux neuronaux doivent-ils être profonds ? 587

20.7 Résumé 590

Exercice 591

_Références 592

CHAPITRE 21 : Apprentissage profond et éthique 597

21.1 Alignement des valeurs 598

21.2 Utilisation abusive intentionnelle 606

21.3 Autres questions sociales, éthiques et professionnelles 608

21.4 Étude de cas 611

21.5 L'idéal de science neutre sur le plan axiologique 612

21.6 Recherche responsable en IA dans une perspective de problème d'action collective 614

21.7 La voie à suivre 615

21.8 Résumé 617

Exercice 618

_Références 620

ANNEXE A Notation 627

A.1 Scalaires, vecteurs, matrices et tenseurs 627

A.2 Variables et paramètres 627

A.3 Ensemble 628

A.4 Fonction 628

A.5 Minimisation et maximisation 629

A.6 Distribution de probabilité 629

A.7 Notation asymptotique 630

A.8 Autres 630

ANNEXE B Concepts mathématiques 631

B.1 Fonction 631

B.2 Coefficient binomial 634

B.3 Vecteurs, matrices et tenseurs 635

B.4 Formes particulières de matrices 639

B.5 Calcul matriciel 641

ANNEXE C Probabilité 643

C.1 Variables aléatoires et distributions de probabilité 643

C.2 Valeur attendue 647

C.3 Distribution de probabilité normale 652

C.4 Échantillonnage 656

C.5 Distance entre les distributions de probabilité 657

Recherche 661

Image détaillée

Dans le livre

Les réseaux neuronaux profonds peuvent traiter des entrées de très grande taille, de longueur variable et présentant divers types de structures internes.

Il peut fournir des probabilités pour un seul nombre réel (régression), plusieurs nombres (régression multivariée) ou deux classes ou plus (classification binaire, classification multiclasse, respectivement).

Comme nous le verrons dans la section suivante, la sortie des réseaux neuronaux profonds peut également être très importante et présenter des structures internes de longueur variable.

--- p.6

Souvent, lorsque nous voulons effectuer plusieurs prédictions à l'aide du même modèle, la sortie y qui est la cible de la prédiction devient un vecteur.

Par exemple, prédire les points de fusion et d'ébullition des molécules (un problème de régression multivariée, Figure 1.2b) ou prédire la classe d'objet à chaque point d'une image (un problème de classification multivariée, Figure 1.4a).

Bien que nous puissions définir des distributions de probabilité multivariées et utiliser des réseaux neuronaux pour modéliser les paramètres du modèle en fonction des entrées, nous traitons généralement chaque prédiction indépendamment.

--- p.91

L'un des principaux problèmes de l'algorithme de descente de gradient est que la destination finale est entièrement déterminée par le point de départ.

La descente de gradient stochastique (SGD) résout ce problème en ajoutant du bruit au gradient à chaque étape.

Cette solution reste en moyenne une solution descendante, mais à un instant donné, la direction choisie n'est pas forcément celle qui descend le plus rapidement.

Il ne s'agit peut-être même pas d'une tendance à la baisse. L'algorithme SGD peut temporairement remonter la courbe, voire passer d'un « creux » à un autre dans la fonction de perte (figure 6.5b).

--- p.111

Un biais apparaît car le modèle ne peut pas représenter correctement la véritable fonction de base.

Par conséquent, cette erreur peut être réduite en rendant le modèle flexible.

Ce problème peut généralement être résolu en augmentant la capacité du modèle.

Pour les réseaux neuronaux, la capacité du modèle peut être augmentée en ajoutant davantage d'unités cachées/couches cachées.

Dans un modèle simple, augmenter la capacité équivaut à ajouter des unités cachées pour diviser l'intervalle [0, 1] en régions plus linéaires.

La figure 8.7ac montre que cela réduit en fait le biais.

Augmenter le nombre de régions linéaires à dix rend le modèle suffisamment flexible pour correspondre étroitement à la fonction réelle.

--- p.168

Dans l'apprentissage auto-supervisé génératif, un sous-ensemble de chaque échantillon de données est masqué et la tâche auxiliaire de prédiction de la partie manquante est effectuée (Figure 9.12c).

Par exemple, nous pouvons utiliser une collection d'images non étiquetées et des opérations auxiliaires pour remplir les parties manquantes des images (Figure 9.12c).

De même, nous masquons certains mots d'un vaste corpus de texte, entraînons un réseau à prédire les mots manquants, puis l'affinons pour la tâche linguistique réelle qui nous intéresse (voir chapitre 12).

Dans l'apprentissage auto-supervisé contrastif, les paires d'échantillons qui ont quelque chose en commun sont comparées à des paires qui n'ont rien en commun.

Pour les images, la tâche auxiliaire consiste à identifier si les paires d'images sont des variantes l'une de l'autre ou si elles sont sans rapport.

Pour le texte, la tâche auxiliaire consiste à vérifier si deux phrases du document original sont contextuellement liées.

Parfois, les tâches auxiliaires nécessitent d'identifier la relation précise entre des paires connectées (par exemple, trouver les positions relatives de deux zones dans la même image).

--- p.201

StyleGAN est un GAN plus moderne qui divise la variabilité d'un ensemble de données en composantes significatives et traite chaque composante comme une variable latente.

StyleGAN, en particulier, redimensionne l'image de sortie à différentes échelles et sépare le style du bruit.

Pour les images faciales, les modifications à grande échelle comprennent la forme du visage et la pose de la tête, les modifications à moyenne échelle comprennent la forme et les détails des traits du visage, et les modifications à fine échelle comprennent la couleur des cheveux et de la peau.

La composante de style représente les aspects de l'image qui sont saillants pour les humains, tandis que la composante de bruit représente les variations sans importance, telles que l'emplacement exact des cheveux, de la barbe, des taches de rousseur et des pores de la peau.

/ Les GAN que nous avons vus jusqu'à présent ont commencé avec une variable latente z tirée d'une distribution de base standard.

Elle traverse une série de couches convolutionnelles pour produire une image de sortie.

Cependant, les entrées de variables latentes du générateur (i) peuvent être appliquées à différents points du réseau neuronal et (ii) peuvent modifier la représentation actuelle à ces points de différentes manières.

StyleGAN sélectionne soigneusement les échelles et sépare le style du bruit (Figure 15.19).

Il peut fournir des probabilités pour un seul nombre réel (régression), plusieurs nombres (régression multivariée) ou deux classes ou plus (classification binaire, classification multiclasse, respectivement).

Comme nous le verrons dans la section suivante, la sortie des réseaux neuronaux profonds peut également être très importante et présenter des structures internes de longueur variable.

--- p.6

Souvent, lorsque nous voulons effectuer plusieurs prédictions à l'aide du même modèle, la sortie y qui est la cible de la prédiction devient un vecteur.

Par exemple, prédire les points de fusion et d'ébullition des molécules (un problème de régression multivariée, Figure 1.2b) ou prédire la classe d'objet à chaque point d'une image (un problème de classification multivariée, Figure 1.4a).

Bien que nous puissions définir des distributions de probabilité multivariées et utiliser des réseaux neuronaux pour modéliser les paramètres du modèle en fonction des entrées, nous traitons généralement chaque prédiction indépendamment.

--- p.91

L'un des principaux problèmes de l'algorithme de descente de gradient est que la destination finale est entièrement déterminée par le point de départ.

La descente de gradient stochastique (SGD) résout ce problème en ajoutant du bruit au gradient à chaque étape.

Cette solution reste en moyenne une solution descendante, mais à un instant donné, la direction choisie n'est pas forcément celle qui descend le plus rapidement.

Il ne s'agit peut-être même pas d'une tendance à la baisse. L'algorithme SGD peut temporairement remonter la courbe, voire passer d'un « creux » à un autre dans la fonction de perte (figure 6.5b).

--- p.111

Un biais apparaît car le modèle ne peut pas représenter correctement la véritable fonction de base.

Par conséquent, cette erreur peut être réduite en rendant le modèle flexible.

Ce problème peut généralement être résolu en augmentant la capacité du modèle.

Pour les réseaux neuronaux, la capacité du modèle peut être augmentée en ajoutant davantage d'unités cachées/couches cachées.

Dans un modèle simple, augmenter la capacité équivaut à ajouter des unités cachées pour diviser l'intervalle [0, 1] en régions plus linéaires.

La figure 8.7ac montre que cela réduit en fait le biais.

Augmenter le nombre de régions linéaires à dix rend le modèle suffisamment flexible pour correspondre étroitement à la fonction réelle.

--- p.168

Dans l'apprentissage auto-supervisé génératif, un sous-ensemble de chaque échantillon de données est masqué et la tâche auxiliaire de prédiction de la partie manquante est effectuée (Figure 9.12c).

Par exemple, nous pouvons utiliser une collection d'images non étiquetées et des opérations auxiliaires pour remplir les parties manquantes des images (Figure 9.12c).

De même, nous masquons certains mots d'un vaste corpus de texte, entraînons un réseau à prédire les mots manquants, puis l'affinons pour la tâche linguistique réelle qui nous intéresse (voir chapitre 12).

Dans l'apprentissage auto-supervisé contrastif, les paires d'échantillons qui ont quelque chose en commun sont comparées à des paires qui n'ont rien en commun.

Pour les images, la tâche auxiliaire consiste à identifier si les paires d'images sont des variantes l'une de l'autre ou si elles sont sans rapport.

Pour le texte, la tâche auxiliaire consiste à vérifier si deux phrases du document original sont contextuellement liées.

Parfois, les tâches auxiliaires nécessitent d'identifier la relation précise entre des paires connectées (par exemple, trouver les positions relatives de deux zones dans la même image).

--- p.201

StyleGAN est un GAN plus moderne qui divise la variabilité d'un ensemble de données en composantes significatives et traite chaque composante comme une variable latente.

StyleGAN, en particulier, redimensionne l'image de sortie à différentes échelles et sépare le style du bruit.

Pour les images faciales, les modifications à grande échelle comprennent la forme du visage et la pose de la tête, les modifications à moyenne échelle comprennent la forme et les détails des traits du visage, et les modifications à fine échelle comprennent la couleur des cheveux et de la peau.

La composante de style représente les aspects de l'image qui sont saillants pour les humains, tandis que la composante de bruit représente les variations sans importance, telles que l'emplacement exact des cheveux, de la barbe, des taches de rousseur et des pores de la peau.

/ Les GAN que nous avons vus jusqu'à présent ont commencé avec une variable latente z tirée d'une distribution de base standard.

Elle traverse une série de couches convolutionnelles pour produire une image de sortie.

Cependant, les entrées de variables latentes du générateur (i) peuvent être appliquées à différents points du réseau neuronal et (ii) peuvent modifier la représentation actuelle à ces points de différentes manières.

StyleGAN sélectionne soigneusement les échelles et sépare le style du bruit (Figure 15.19).

--- p.410

Avis de l'éditeur

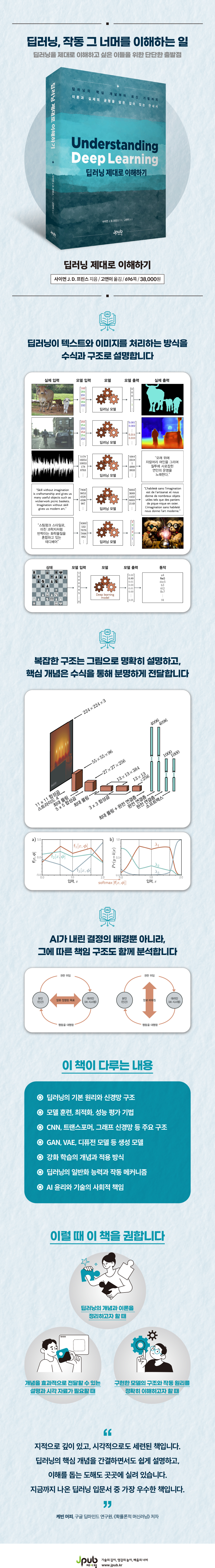

Un nouveau classique qui aborde la théorie de l'apprentissage profond et les dernières tendances.

L'apprentissage profond a révolutionné le domaine scientifique et a eu un impact significatif sur la société dans son ensemble, grâce aux recherches persistantes de Yoshua Bengio, Geoffrey Hinton et Yann LeCun, qui mènent des recherches depuis plus de 25 ans.

Pourtant, rares sont encore les personnes qui « comprennent vraiment » l'apprentissage profond.

Ce livre couvre un large éventail de sujets, des principes fondamentaux de l'apprentissage profond aux architectures de pointe comme les transformateurs et les modèles de diffusion, en dévoilant de manière systématique et intuitive des sujets complexes.

Des références actualisées, des exemples pratiques et de riches supports visuels facilitent l'apprentissage et aident les lecteurs à approfondir leur compréhension.

Ce livre va bien au-delà d'un simple guide technique et présente une perspective globale, allant de la question fondamentale « Pourquoi l'apprentissage profond est-il efficace ? » à l'éthique de l'IA.

Le chapitre 1 présente l'apprentissage profond, et les chapitres 2 à 9 couvrent l'ensemble du processus d'apprentissage supervisé.

Nous expliquerons l'architecture des réseaux neuronaux superficiels et profonds, et nous explorerons comment les entraîner, mesurer leurs performances et les améliorer.

Les chapitres 10 à 13 couvrent les structures représentatives des réseaux neuronaux profonds, telles que les réseaux neuronaux convolutifs, les connexions résiduelles et les transformateurs, et expliquent comment ces structures sont utilisées dans l'apprentissage supervisé, l'apprentissage non supervisé et l'apprentissage par renforcement.

Les chapitres 14 à 18 couvrent l'apprentissage non supervisé, en se concentrant sur les modèles génératifs profonds tels que les réseaux antagonistes génératifs (GAN), les auto-encodeurs variationnels (VAE), le flux de régularisation et les modèles de diffusion.

Le chapitre 19 présente brièvement l'apprentissage par renforcement profond, et le chapitre 20 explore des concepts clés tels que la double descente, le groking et l'hypothèse du billet de loterie, abordant des questions fondamentales telles que « Pourquoi l'apprentissage profond généralise-t-il bien ? », « Pourquoi les réseaux neuronaux doivent-ils être si profonds ? » et « Pourquoi avons-nous besoin d'autant de paramètres ? »

Enfin, le chapitre 21 aborde l'apprentissage en profondeur et l'éthique.

L'annexe résume les connaissances de base essentielles, notamment la notation, les concepts mathématiques et les probabilités, afin de vous aider à suivre les concepts sans interrompre le déroulement de l'apprentissage.

De plus, toutes les images incluses dans le livre peuvent être visualisées en couleur via des codes QR, ce qui renforce encore l'effet d'apprentissage.

Ce livre n'est ni un ouvrage théorique, ni un ouvrage pratique.

Il n'y a aucune preuve et très peu de code.

Il offre plutôt une compréhension approfondie et claire des concepts fondamentaux de l'apprentissage profond, et fournit une base conceptuelle permettant de trouver soi-même des solutions, même face à de nouveaux problèmes où les formules de réussite existantes ne s'appliquent pas.

Chaque chapitre est structuré de manière à vous permettre de comprendre et de résoudre fondamentalement les problèmes rencontrés dans la vie réelle.

Voici la naissance d'un nouveau classique de l'apprentissage profond pour ceux qui veulent comprendre l'apprentissage profond depuis le début, en profondeur et correctement.

Je recommande ceci dans ces situations

● Lorsque vous souhaitez organiser les concepts et les théories de l'apprentissage profond

● Lorsque vous avez besoin d'explications et d'aides visuelles pour transmettre efficacement un concept

● Lorsque vous souhaitez comprendre précisément la structure et les principes de fonctionnement du modèle mis en œuvre

Contenu principal

● Principes de base de l'apprentissage profond et structure des réseaux neuronaux

● Techniques d'entraînement, d'optimisation et d'évaluation des performances des modèles

● Structures clés telles que les CNN, les transformeurs et les réseaux neuronaux graphiques

Les modèles génératifs tels que les GAN, les VAE et les modèles de diffusion

● Concept et application de l'apprentissage par renforcement

● Capacité de généralisation et mécanisme de fonctionnement de l'apprentissage profond

● L’éthique de l’IA et la responsabilité sociale des technologies

L'apprentissage profond a révolutionné le domaine scientifique et a eu un impact significatif sur la société dans son ensemble, grâce aux recherches persistantes de Yoshua Bengio, Geoffrey Hinton et Yann LeCun, qui mènent des recherches depuis plus de 25 ans.

Pourtant, rares sont encore les personnes qui « comprennent vraiment » l'apprentissage profond.

Ce livre couvre un large éventail de sujets, des principes fondamentaux de l'apprentissage profond aux architectures de pointe comme les transformateurs et les modèles de diffusion, en dévoilant de manière systématique et intuitive des sujets complexes.

Des références actualisées, des exemples pratiques et de riches supports visuels facilitent l'apprentissage et aident les lecteurs à approfondir leur compréhension.

Ce livre va bien au-delà d'un simple guide technique et présente une perspective globale, allant de la question fondamentale « Pourquoi l'apprentissage profond est-il efficace ? » à l'éthique de l'IA.

Le chapitre 1 présente l'apprentissage profond, et les chapitres 2 à 9 couvrent l'ensemble du processus d'apprentissage supervisé.

Nous expliquerons l'architecture des réseaux neuronaux superficiels et profonds, et nous explorerons comment les entraîner, mesurer leurs performances et les améliorer.

Les chapitres 10 à 13 couvrent les structures représentatives des réseaux neuronaux profonds, telles que les réseaux neuronaux convolutifs, les connexions résiduelles et les transformateurs, et expliquent comment ces structures sont utilisées dans l'apprentissage supervisé, l'apprentissage non supervisé et l'apprentissage par renforcement.

Les chapitres 14 à 18 couvrent l'apprentissage non supervisé, en se concentrant sur les modèles génératifs profonds tels que les réseaux antagonistes génératifs (GAN), les auto-encodeurs variationnels (VAE), le flux de régularisation et les modèles de diffusion.

Le chapitre 19 présente brièvement l'apprentissage par renforcement profond, et le chapitre 20 explore des concepts clés tels que la double descente, le groking et l'hypothèse du billet de loterie, abordant des questions fondamentales telles que « Pourquoi l'apprentissage profond généralise-t-il bien ? », « Pourquoi les réseaux neuronaux doivent-ils être si profonds ? » et « Pourquoi avons-nous besoin d'autant de paramètres ? »

Enfin, le chapitre 21 aborde l'apprentissage en profondeur et l'éthique.

L'annexe résume les connaissances de base essentielles, notamment la notation, les concepts mathématiques et les probabilités, afin de vous aider à suivre les concepts sans interrompre le déroulement de l'apprentissage.

De plus, toutes les images incluses dans le livre peuvent être visualisées en couleur via des codes QR, ce qui renforce encore l'effet d'apprentissage.

Ce livre n'est ni un ouvrage théorique, ni un ouvrage pratique.

Il n'y a aucune preuve et très peu de code.

Il offre plutôt une compréhension approfondie et claire des concepts fondamentaux de l'apprentissage profond, et fournit une base conceptuelle permettant de trouver soi-même des solutions, même face à de nouveaux problèmes où les formules de réussite existantes ne s'appliquent pas.

Chaque chapitre est structuré de manière à vous permettre de comprendre et de résoudre fondamentalement les problèmes rencontrés dans la vie réelle.

Voici la naissance d'un nouveau classique de l'apprentissage profond pour ceux qui veulent comprendre l'apprentissage profond depuis le début, en profondeur et correctement.

Je recommande ceci dans ces situations

● Lorsque vous souhaitez organiser les concepts et les théories de l'apprentissage profond

● Lorsque vous avez besoin d'explications et d'aides visuelles pour transmettre efficacement un concept

● Lorsque vous souhaitez comprendre précisément la structure et les principes de fonctionnement du modèle mis en œuvre

Contenu principal

● Principes de base de l'apprentissage profond et structure des réseaux neuronaux

● Techniques d'entraînement, d'optimisation et d'évaluation des performances des modèles

● Structures clés telles que les CNN, les transformeurs et les réseaux neuronaux graphiques

Les modèles génératifs tels que les GAN, les VAE et les modèles de diffusion

● Concept et application de l'apprentissage par renforcement

● Capacité de généralisation et mécanisme de fonctionnement de l'apprentissage profond

● L’éthique de l’IA et la responsabilité sociale des technologies

SPÉCIFICATIONS DES PRODUITS

- Date d'émission : 28 août 2025

- Nombre de pages, poids, dimensions : 696 pages | 188 × 245 × 33 mm

- ISBN13 : 9791194587262

Vous aimerez peut-être aussi

카테고리

Langue coréenne

Langue coréenne

![ELLE 엘르 스페셜 에디션 A형 : 12월 [2025]](http://librairie.coreenne.fr/cdn/shop/files/b8e27a3de6c9538896439686c6b0e8fb.jpg?v=1766436872&width=3840)